Falsos positivos, verdadeiros dilemas: detectores de texto IA funcionam?

A solução tecnológica da detecção de texto gerado por Inteligência Artificial levanta questões sobre sua eficácia e impacto no processo educacional

Bem-vindos a mais uma edição da IAEdPraxis, sua fonte de informação para explorar os caminhos da Inteligência Artificial aplicada à Educação.

Esta edição continua a série dedicada ao uso da IA Generativa para a escrita, incluindo sua relação com as debilidades do texto "texto GPT" e o uso antiético da IA. Mas agora vamos abordar as ferramentas de detecção deste tipo de "plágio", apontadas como solução para o problema da fraude acadêmica. Mas serão realmente?

IA em Foco

Por Marcelo Sabbatini

A esta altura dos acontecimentos, passados pouco mais de dois anos do lançamento do ChatGPT, já se tornou uma constante na rotina de professores: trabalhos surpreendentemente bem escritos, mas que destoam do que se poderia esperar daquele aluno, sem falar nas idiossincrasias do "texto GPT". Mais um caso de autoria delegada, do que poderia ser considerado um deslize ético ou mesmo uma violação da integridade acadêmica.

Mas como ter certeza de que o aluno usou IA? Como é usual, surgem soluções tecnológicas para problemas causados pela tecnologia. Os detectores de texto gerado por Inteligência Artificial, também chamado de "plágio de IA" surgem com a aura de infalibilidade que geralmente associamos á Inteligência Artificial. Porém, além de ser injustificada, eles podem trazer ainda mais problemas. Um ambiente de desconfiança mútua e carreiras acadêmicas "canceladas" são alguns dos pontos que nos fazem questionar: podemos (ou devemos) usar estes detectores?

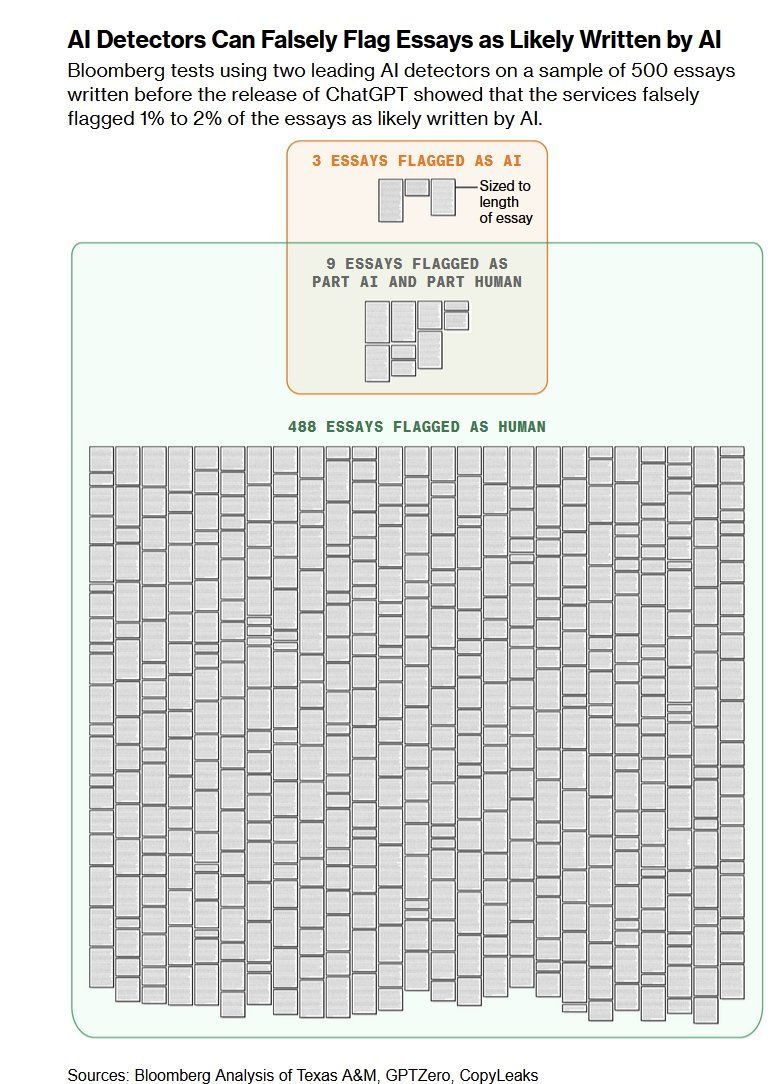

Quando a tecnologia falha: os falsos positivos

Uma reportagem publicada na revista Bloomberg levantou sérios e vários questionamentos sobre os detectores de texto IA. O ponto de partida, um teste realizado por outra revista, a Businesweek, que comparou 500 cartas de candidatura a uma universidade escritas no verão de 2022, um pouco antes do lançamento do ChatGPT. Mesmo não podendo ter sido geradas por Inteligência Artificial, as ferramentas testadas classificaram entre 1 e 2% dos textos como tal.

Parece ser uma característica intrínseca da tecnologia: nosso conhecido software de detecção de plágio Turnitin , que agora inclui a "detecção de escrita de IA", assume uma taxa de 1% de falsos positivos. Mas como e por que eles ocorrem? E quais são as consequências?

Trata-se do chamado "falso positivo", ou seja, quando algo que não existe ou não está presente é identificado por um teste. No caso de textos supostamente gerados por IA, as razões podem ser muitas, incluindo alunos no espectro autista que escrevem de maneira formulaica, aqueles que escrevem de forma genérica ou que tenham desenvolvido um estilo mais mecânico. Especialmente, o texto de alunos não-nativos do idioma tem maior possibilidade de ser sinalizado, fato já evidenciado por pesquisas.

José Antonio Bowene e C. Edward Watson relatam um caso chamativo, em seu livro "Teaching with AI: A Practical Guide to a New Era of Human Learning" (Ensinando com IA: Um Guia Prático Para a Nova Era da Aprendizagem Humana, em tradução livre): o trabalho de um aluno levantou suspeitas, foi passado numa ferramenta de detecção, com resultado positivo. Apesar do aluno afirmar que havia feito o trabalho por conta própria, o corpo docente continuou a duvidar. Para demonstrar então a falta de confiabilidade da tecnologia, o estudante aplicou o detector aos artigos de pesquisa dos próprios professores, também encontrando resultados "positivos". O episódio aumentou ainda mais as tensões no campus.

Por uma boa razão: ser acusado e julgado por fraude acadêmica pode ter grande impacto não somente para a vida estudantil - indo de uma suspensão à perda de bolsas ou mesmo uma expulsão - mas para a futura atuação profissional. Numa discussão sobre a confiabilidade da ferramenta Copyleaks, por exemplo, um usuário expressou preocupação em não ser aceito em processos de seleção, devido à falta de precisão da ferramenta.

Como consequência, o clima de desconfiança leva a alunos se gravarem enquanto escrevem seus trabalhos ou registrarem as mudanças em ferramentas como o Google Docs, como forma de gerar evidências e documentar a autoria. Paranoia e ansiedade começam a tomar conta das salas de aula.

Logo, também há a questão de privacidade e de propriedade intelectual dos alunos. As instituições precisariam dispor de modelos legais extremamente sólidos para enviar os trabalhos para plataformas tecnológicas que farão uso destes dados para treinamento da IA.

"No atual momento, a maioria dos detectores de IAG, notadamente os gratuitos, não são confiáveis!"

Entre os princípios práticos do uso ético e responsável da IA em pesquisa, a detecção automática é assinalada com um grande "cuidado". Mais além da confiabilidade, seu uso precisa ser amparado por diretrizes institucionais, além de comitês específicos capazes de julgar estes casos. Saiba mais, neste guia gratuito.

Nesta discussão, é importante lembrar que as ferramentas de detecção de texto IA são serviços/produtos, inclusive sendo incorporadas aos detectores do plágio mais "tradicional" como a mencionada Turnitin. Desde 2029, segundo a reportagem, as startups de detecção atraíram mais de 28 milhões de dólares de investimento. Ou seja, há uma pressão econômica para sua adoção.

Somando todos problemas, o uso de detectores tem sido revogado por políticas institucionais. Como relata o professor Lance Eaton, estas ferramentas fornecem apenas uma "probabilidade sem evidência", ainda mais por que seu funcionamento interno não é conhecido, nem validado externamente. Usar detectores, seria então "apostar numa máquina que não tem obrigação (financeira ou legal) de nos ajudar com a verdade" e jogar o resultado contra um estudante

"Isso [o resultado de um detector, expresso em porcentagens] dá clareza, dá uma aparência de precisão, nos dá sensação de certeza. E é tudo besteira. Permite que evitemos o verdadeiro trabalho de ensinar, que também inclui um trabalho investigativo - descobrir o que os alunos realmente aprenderam e não aprenderam".

Lance Eaton

Mas afinal, como funcionam os detectores de IA?

Ainda que os algoritmos sejam opacos em sua operação, alguns critérios são divulgados pelas empresas, a exemplo da "perplexidade", uma medida da complexidade dos termos utilizados. Dito de outra forma, palavras mais genéricas e previsíveis aumentam a chance de detecção.

Além disso, o fator "burstiness" (variação ou irregularidade) reflete como a perplexidade varia ao longo do documento, sendo que nós humanos tendemos a variar mais a "voz de um texto".

Outra empresa de destaque, a Copyleaks, afirma treinar seus modelos desde 2025, com objetivo de compreender os padrões da escrita humana e, assim, identificar as regularidades típicas dos textos gerados por IA. Através de um sistema de sistema de feedback, pelo qual os usuários podem podem avaliar a precisão dos resultados, busca estabelecer um ciclo contínuo de aprendizado. Entretanto, surgem críticas em relação aos números promovidos pela empresa, assim como pelas fontes de treinamento e pelos vieses e preconceitos na determinação do que constitui a "escrita humana".

De modo geral, a falta de transparência sobre critérios e metodologias fazem com que educadores e instituições tenham que confiar cegamente em um sistema que pode ter impactos significativos na vida acadêmica de seus estudantes.

Em vídeo divulgado após as reações negativas diante da falibilidade da tecnologia, o cientista de dados David Adamsom da Turnitin apontou a principal característica do texto generativo que contribui para sua identificação: repetição, tanto no uso repetido de palavras, como na redundância de ideias.

Além disso, o tecnólogo destacou que a ferramenta somente deve ser utilizada com parágrafos completos, em língua inglesa. Não seria, portanto, precisa em textos contendo listas ou de gêneros como a poesia.

Afirmando que os critérios utilizados se orientam à precisão e à justiça, errando por menos, uma expressão chama a atenção: "a confiabilidade de nossas previsões". Ou seja, não existe uma precisão absoluta, a IA não é um juiz imparcial e infalível. Ela atua num espaço de possibilidades, sua "alma", por assim dizer é a Estatística, sempre é bom lembrar.

Mas também há um ponto problemático na fala, que precisa ser discutido. Não fica claro se a restrição ao inglês foi uma forma de falar, um equívoco por parte do cientista, ou se realmente há uma limitação neste sentido.

Neste momento, o software está sendo comercializado no Brasil, incluindo a funcionalidade de detecção de texto IA. Mas a base de treinamento utiliza textos em Língua Portuguesa? Está adaptada a nosso contexto? O risco de viés, com a diminuição da precisão alegada, pode ser inaceitável em termos das repercussões que pode trazer para a vida acadêmica.

Feitiço contra o feiticeiro?

Assim como surgem ferramentas de IA para detectar texto escrito por IA, agora temos ferramentas de IA para disfarçar texto escrito por IA. Um ciclo interminável, aparentemente, uma "rinha de tecnologias" que tem como efeito abalar a confiança entre educadores e alunos.

Como exemplo, a Stealth Writer promete "converter conteúdo gerado por IA em conteúdo humano e circunscrever detectores como Turnitin, GPTZero, Originality AI". Justamente, ao incorporar variações de estilo, pequenas inconsistências e padrões linguísticos que mimetizam o processo natural de escrita, os detectores seriam enganados e o texto "humanizado".

Mesmo a verificação da escrita entendida como processo está em xeque, diante dos desdobramentos tecnológicos. Neste momento, já temos relatos agentes de IA que atuam em Documentos Google, simulando os padrões de escrita e de edição realizados por um humano. Dessa forma, o histórico do documento revelaria que ele foi "escrito" e não "copiado e colado".

Finalmente, além das ferramentas automatizadas, as técnicas "manuais" são utilizadas pelos alunos para evadir a detecção. A edição do conteúdo gerado, incorporando elementos como dados e estatísticas, citações contextualizadas e exemplos concretos, adiciona camadas de autenticidade. Estratégias estilísticas como a "regra das três unidades" (desenvolvimento de ideias em três frases encadeadas) e o princípio do "mostrar, não contar" dão mais naturalidade ao texto. A inclusão deliberada de conteúdo emocional - aspecto em que as máquinas ainda falham - e o uso de metáforas também mascaram a origem artificial do texto. Combinadas com correções gramaticais e ajustes sintáticos, os detectores se tornam inúteis. Por outro lado, todo este trabalho de edição envolvido proporcione uma boa dose de autoria!

Alternativas à detecção automática

Diante dos impasses levantados, os detectores de IA começam a ser questionados. O posicionamento da Vanderbilt University, nos Estados Unidos, é marcante. Depois de meses utilizando e testando a ferramenta, a instituição desabilitou a função de detecção de texto IA, sem previsão de utilizá-la num futuro próximo.

Em sua argumentação, a Universidade destaca o efeito quantitativo da taxa de falsos positivos de 1% alegada pela Turnintin. Em seu contexto, dos 75 mil trabalhos produzidos num ano, 750 seriam incorretamente classificados como produzidos pela IA.

Logo, a preocupação com a privacidade dos dados fornecidos pelos estudantes também pesou na decisão. Frente a um desafio tecnológico que somente aumentará diante da capacidade das IAs, a eficácia da ferramenta foi seriamente questionada.

Diante da opção de não utilizar ferramentas para a detecção de texto IA, a Vanderbilt University faz algumas recomendações para seus professores (e para a comunidade acadêmica, em geral).

Um primeiro ponto a ser considerado seria a comunicação das expectativas a respeito do uso de IA, no sentido do que é permitido ou proibido. Os impactos para a formação e para as futuras competências profissionais também entrariam nesta atitude de abertura, que idealmente deve estar amparada por normativas institucionais sobre o uso ético da Inteligência Artificial.

Logo, também recomenda comparar o texto com escritas prévias do estudante, em casos de suspeita. Além das características do "texto GPT", mudanças no estilo, no tom, na capacidade de articulação e no desenvolvimento de ideias podem indicar o uso de IA. Em relação ao conteúdo, informações inexatas, sem atribuição de fonte e referências inexistentes apontam para a alucinação das IAs generativas. Todos estes critérios são percebidos por professor atento.

Finalmente, e como temos comentado, uma mudança na natureza das tarefas pedagógicas deve ser contemplada, como atividades que incluam a escrita durante aulas presenciais. Temas atuais e/ou muito específicos, para as quais os modelos de IA não possuam treinamento também compõe um conjunto de "atividades imunes à IA".

Por sua vez, a Turnitin, em sua estratégia de comunicação pública, defende uma convivência pedagógica. Para Annie Chechitelli, chefe de produto empresa, o impacto que mesmo 1% de falsos positivos pode ter sobre a vida acadêmica dos estudantes deve ser considerado. Para ela, as pontuações produzidas pela ferramenta podem ser o ponto de partida para um "diálogo significativo e impactante" com os estudantes.

Em seu discurso e nas ações de suporte aos usuários, a empresa tem se colocado como protetora dos "pilares da integridade acadêmica", não numa perspectiva punitivista, mas como contribuição para a construção de uma cultura de escrita acadêmica eticamente orientada.

"Semelhante à fraude acadêmica, usar IA para escrever uma tarefa não é, tecnicamente, plágio. Nenhum trabalho original está sendo copiado. Mas, ao mesmo tempo, não é o trabalho original do aluno. De muitas maneiras, a escrita por IA e a fraude acadêmica são muito semelhantes; no domínio da fraude acadêmica, os alunos enviam um pedido a um site de compra e venda de trabalhos e recebem uma dissertação em troca. Protegemos a verdadeira intenção que há por trás da aprendizagem e da aquisição de conhecimento".

Chris Caren

Numa entrevista recente, o CEO da Turnitin, Chris Caren tratou de posicionar a ferramenta como auxiliar e intermediária de aprendizagem. Esta postura se reflete na terminologia; em diversos textos de seu blog a comunicação institucional destaca que o software "não detecta plágio". Em suas próprias palavras, "não faz uma determinação de má conduta, mesmo no espaço de similaridade de texto; ao invés disso, fornece dados para que os professores tomem uma decisão pautada e com base em suas políticas acadêmicas e institucionais".

O que fazer ao suspeitar do uso de IA?

Em poucas palavras, o fato é que não há uma solução fácil. A abordagem do tema exige tempo e atenção individualizada, tratando cada caso em sua singularidade. Uma vez levantada uma suspeita - de forma automatizada ou humana - manter um diálogo aberto e construtivo pode ser um caminho.

Assim, uma abordagem mista combinaria a avaliação tradicional com discussões aprofundadas sobre integridade acadêmica, valor da autoria e uso ético da tecnologia. Amparada por políticas institucionais claras e informativas, esta conduta ao uso isolado de ferramentas de detecção.

Quando um estudante é chamado para "a conversa", como sugere Eaton, a instituição está comunicando a valorização do debate sobre a tecnologia, mas levando em conta também a perspectiva do aluno. Mais do que um "ahá, te peguei!", cada episódio é uma oportunidade para compreender o contexto e as motivações. Não se trata simplesmente de determinar "usou" ou "não "usou", mas compreender mais sobre como as ferramentas de IA generativa podem tanto apoiar quanto interferir no aprendizado.

Entretanto, nas situações nas quais o estudante nega o uso da IA, mesmo diante de fortes indícios, a "conversa" irá tomar outro rumo. Neste momento, perguntas sobre o processo de desenvolvimento do texto, as fontes consultadas e principalmente sobre o raciocínio por trás de certos argumentos podem revelar o nível de compreensão e de comprometimento com autoria. Ao explicar como chegou às conclusões, elaborar sobre conceitos específicos ou relacionar com temas debatidos em aula, o professor poderá estimar em que medida o trabalho foi genuinamente realizado pelo estudante. Já hesitações, inconsistências ou dificuldades em explicar o próprio texto, apontam para um texto automatizado e descompromissado.

E agora?

Em sua entrevista, o presidente da Turnitin foi taxativo: a escrita por IA é um "caminho sem volta”. E pela forma como a tecnologia está se desenvolvendo e sendo utilizada por nossos alunos, de alguma forma precisamos nos preparar e adaptar.

Embora tenhamos destacado os riscos e limitações dos detectores de IA, eles podem ter um papel complementar (ainda que limitado) em estratégias mais amplas de integridade acadêmica.

Como relata Anna Mills, educadora e especialista em escrita acadêmica que durante dois anos se posicionou de forma contrária à detecção automática, relatou uma situação na qual os limites de estratégias de incentivo à autoria se esgotaram. E foi justamente a possibilidade da fraude ser detectada, no processo de revisão de notas, que fez o estudante admitir o uso de IA.

Encontrar um equilíbrio entre o uso crítico da tecnologia e a preservação dos valores fundamentais do processo de ensino-aprendizagem exige flexibilidade de pensamento.

Queremos ouvir você! Suas ideias e experiências são valiosas para aprofundar esta conversa. Não hesite em compartilhar seus pensamentos, relatos ou dúvidas conosco.

Ótimo artigo, Marcelo, discute bem os dilemas da IA na educação. Particularmente quanto à Ead, acho que TODAS as formas assincronicas de avaliação do aprendizado estão liquidadas. Vamos, como professores, adotar uma atitude de “deixa prá lá…” ou vamos contra-atacar com metodologia pré-internet, tais como os exames orais um-a-um dos meus tempos de estudante (as famosas sabatinas, pois eram realizadas sempre aos sábados… favor não confundir com nosso sobrenome, ahahah!)