Avaliação em tempos de Inteligência Artificial

Entre o temor à "cola" e o desafio de reimaginar provas e tarefas

Bem-vindos a mais uma edição de IAEdPraxis, sua fonte de informação para explorar os caminhos da Inteligência Artificial aplicada à Educação. Esta semana revisamos pesquisas científicas que abordam um dos grandes "nós" do debate sobre IA, o impacto sobre as atividades avaliativas.

IA em Foco

Por Marcelo Sabbatini

Desde que o ChatGPT & cia. chegaram com força no cenário educacional, a discussão sobre o impacto da Inteligência Artificial na Educação se intensificou em todas as frentes. Mas talvez nenhuma área tenha gerado tanto alarme e debate quanto a avaliação. Afinal, se uma máquina pode gerar textos coerentes, resolver problemas e até simular conhecimento, como saber se um trabalho entregue por um estudante reflete seu aprendizado real ou simplesmente o acesso a uma IA? O fantasma do "cola" instantânea se instalou nas salas dos professores e nas instituições.

Essa preocupação é válida e compreensível. A avaliação é um pilar central do processo educativo, não apenas para medir o aprendizado, mas também para guiar o ensino e certificar competências. A chegada da IA Generativa desestabilizou métodos e práticas que usamos há tempos, especialmente aqueles baseados em produção textual ou resolução de problemas padronizados que estão fora do controle direto do professor. Para muitos, a primeira reação foi (e ainda é) proibir o uso da IA em atividades avaliativas, com o uso de ferramentas de detecção ou mesmo retornado a formatos "à moda antiga" (provas orais, presenciais).

No entanto, um olhar mais aprofundado com apoio de resultados de pesquisa acadêmica nos mostram que a relação entre IA e avaliação é bem mais complexa e multifacetada do que a simples equação "IA = cola". Artigos recentes têm buscado mapear como a IA está, de fato, impactando a avaliação, e o que está emergindo não são respostas fáceis, mas um campo de desafios e oportunidades que exigem o nosso engajamento ativo.

O que percebemos, ao analisar estes estudos é que a IA toca a avaliação em múltiplas camadas – impactando estudantes, professores e instituições – e de formas que vão além da integridade acadêmica. Há, sim, a questão da fraude, que se torna mais visível e desafiadora. Mas há também potencial para o desenvolvimento do letramento digital dos estudantes e professores, e para um repensar necessário sobre para que serve a avaliação na era digital.

O espelho e o martelo: impactos da IA na avaliação em três níveis

Ao analisar o cenário da IA e avaliação no ensino superior, pesquisas como A scoping review on how Generative Artificial Intelligence transforms assessment in Higher Education (Uma revisão de escopo sobre como a Inteligência Artificial Generativa transforma a avaliação no Ensino Superior, em tradução livre) de Xia et al. (2024) evidenciam que os impactos se manifestam em diferentes níveis, cada um com suas oportunidades e desafios particulares.

No nível dos estudantes, a IA pode ser uma ferramenta para o aprendizado e a autoavaliação, oferecendo feedback rápido. As atuais ferramentas podem ajudar a verificar a compreensão de conceitos ou sugerir roteiros de estudo, segundo a utilização de prompts específicos. No entanto, desafio aqui é a tentação e a facilidade de usar a IA para burlar o processo, gerando trabalhos que não refletem o seu esforço intelectual. A integridade acadêmica se torna um ponto de atenção constante, exigindo repensar o desenho das tarefas.

Para os docentes, a IA apresenta a possibilidade de otimizar algumas etapas da avaliação, talvez ajudando na criação de rubricas, na avaliação de produções escritas (sem substituir a leitura atenta e o julgamento humano) ou na formulação de atividades que geralmente demandam bastante esforço. No entanto, o uso da IA também exige que o professor desenvolva um nov "letramento em avaliação com tecnologia", aprendendo a desenhar avaliações que considerem a existência da IA, a equilibrar a avaliação feita por humanos e a possível assistência da máquina, e a focar em habilidades que a IA atual não domina (criatividade, empatia...). Isso, claro, demanda bastante tempo e formação contínua.

Já para as instituições, o impacto é sistêmico, com a pressão para uma revisão completa das políticas de avaliação. É preciso pensar em novas diretrizes sobre o uso (permitido ou não, e sob quais condições) da IA em trabalhos e exames. Há a necessidade de desenvolver programas de formação para professores e estudantes sobre o uso ético da IA. Um passo além, o próprio currículo demanda ser repensado, por exemplo valorizando ainda mais o pensamento crítico, a criatividade, a resolução de problemas complexos e o aprendizado contínuo – habilidades que se tornam ainda mais relevantes num mundo com IA. A questão é: como fazer tudo isso de forma que a avaliação continue significativa e justa?

Em suma, a IA funciona como um espelho que reflete as fragilidades dos nossos métodos de avaliação atuais (especialmente aqueles facilmente automatizáveis ou replicáveis por IA) e, ao mesmo tempo, como um martelo que quebra as práticas solidificadas, forçando (ou permitindo) o redesenho. Entender esses impactos nos diferentes níveis é o ponto de partida para navegar esse cenário.

Repensando a casa: quadros, diretrizes e o desafio da implementação

Diante dos impactos multifacetados da IA na avaliação, o campo da Educação tem buscado ativamente formas de responder e se adaptar. Não estamos parados. Esse movimento se manifesta na criação de quadros ou esquemas (frameworks), no desenvolvimento de diretrizes institucionais e na tentativa de (re)pensar a própria prática pedagógica.

Um exemplo desse esforço é a proposta do artigo Developing the Technology-Integrated Assessment Framework (Desenvolvendo o Framework de Avaliação Integrada à Tecnologia, em tradução livre) de Madland et al. (2024). Reconhecendo as lacunas nos modelos existentes, os autores propõem uma estrutura para pensar a avaliação integrada com tecnologia que vai além das ferramentas e tarefas, abordando aspectos como o propósito da avaliação, o "dever de cuidado" (duty of care) com os estudantes (incluindo ética e equidade) e a assimilação da tecnologia. Essa perspectiva mais ampla busca garantir que a integração tecnológica, incluindo a IA, seja pedagogicamente sólida e eticamente responsável, e não apenas um "verniz tecnológico". A inclusão de perspectivas como os "Cinco Rs" da Educação Indígena neste quadro, focando em respeito, relevância e relacionamentos, reforça a busca por abordagens mais humanas e contextuais, mesmo com o uso de tecnologia.

Paralelamente, as instituições de ensino têm respondido à sua maneira. Em Mapping the response to AI and its impact on assessment redesign through document analysis (Mapeando a resposta à IA e seu impacto no redesenho de avaliações através da análise documental,em tradução livre), El Khoury (2024) identifica as diretrizes de diversas universidades, mostra que a resposta inicial foi variada e, em grande parte, reativa — uma "primeira onda" de orientações que buscam trazer clareza para professores e estudantes. Essas diretrizes tentam definir terminologias (um desafio, dada a variedade de termos), estabelecer princípios provisórios para o uso da IA em avaliação e oferecer conselhos práticos aos professores. Exemplos como a Universidade de Guelph discutindo o impacto multifacetado da IA ou o British Columbia Institute of Technology questionando o valor de atividades que podem ser automatizadas por IA mostram que o debate está posto.

No entanto, é importante notar que essas respostas estão em constante evolução. As diretrizes iniciais são provisórias, a terminologia ainda confusa, e a implementação prática enfrenta desafios. A detecção do uso não autorizado de IA, por exemplo, é reconhecida por algumas instituições como difícil ou impraticável. Isso reforça a ideia de que focar apenas na "fiscalização" talvez não seja o caminho mais eficaz ou sustentável.

O que esses esforços de resposta nos mostram é que a comunidade acadêmica está se movendo. Há um reconhecimento da necessidade de quadros conceituais e metodológicos que guiem a prática, de diretrizes que ofereçam um ponto de partida e de um repensar sobre o que e como avaliamos.

A mão na roda que ainda emperra: desafios práticos e o "peso aditivo"

Apesar dos enquadramentos emergentes e das diretrizes institucionais, a integração da IA na avaliação enfrenta desafios no dia a dia do educador e da instituição. Olhando de perto para o que as pesquisas e a prática sugerem, percebemos que a ajuda prometida pela tecnologia não se concretiza.

Um ponto que chama a atenção nestas pesquisas é que, embora se fale muito em eficiência e em usar a IA para ajudar o professor, há pouca clareza ou recomendação sobre o que deve ser "tirado do mochila" do docente. Muitos dos debates e das propostas parecem adicionar tarefas – aprender a usar novas ferramentas, redesenhar avaliações, monitorar o uso de IA – sem compensar diminuindo a carga de trabalho em outras áreas. Isso cria uma sensação de peso adicional num contexto que já exige bastante dos professores.

Outro desafio reside na prática do redesenho. Dizer que é preciso focar em avaliações mais autênticas, que exijam pensamento crítico ou colaboração, é um passo. Mas como redesenhar todas as avaliações de uma disciplina ou curso, em larga escala, mantendo a qualidade e a equidade? Esse processo demanda tempo, conhecimento profundo em design instrucional e avaliação, e apoio institucional robusto – recursos que nem sempre estão disponíveis.

Além disso, a pesquisa Reinventing assessments with ChatGPT and other online tools: opportunities for GENAI-empowered assessment practices (Reinventando avaliações com ChatGPT e outras ferramentas online: oportunidades para práticas de avaliação potencializadas pela Inteligência Artificial Generativa, em tradução livre)de Foung, Lin e Chen (2024), ao analisar a experiência dos estudantes, revela que a questão da equidade no uso da IA também surge do lado de quem é avaliado. Se algumas ferramentas de IA (inclusive aquelas que poderiam auxiliar no estudo ou na revisão) têm versões premium com capacidades superiores, o acesso desigual a essas ferramentas pode criar novas disparidades. Por outro lado, a recomendação de instituições fornecerem acesso a versões pagas de IAs levanta questões de custo e viabilidade em larga escala.

A própria natureza "primeira onda" das diretrizes institucionais aponta para a incerteza e a evolução constante. Os desafios práticos reforçam a ideia de que a IA não é uma solução mágico para os problemas de avaliação. Ela expõe nossas fragilidades (métodos ultrapassados, sobrecarga docente, desigualdades de acesso) e exige um esforço coordenado e contínuo para ser integrada de forma construtiva. O foco não pode ser apenas em "adicionar IA", mas em repensar o sistema de avaliação de forma mais ampla. Em considerar o que é factível, justo e que realmente contribui para o aprendizado.

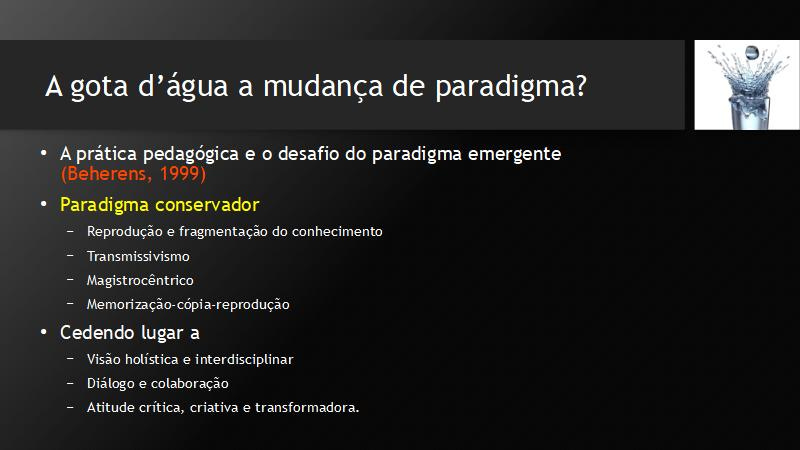

O educador no centro do redesenho: para além do pânico moral

Ao final desta reflexão sobre a IA e a avaliação, percebemos um cenário complexo, marcado tanto pelo potencial transformador quanto por desafios significativos e, sim, pelo medo de perder o controle sobre o processo avaliativo. Modelos de avaliação focados apenas na memorização ou na produção de conteúdo facilmente replicável já estavam em xeque há tempos. A Inteligência Artificial aparece como a gota d'água para nos fazer repensar o que realmente valorizamos e queremos avaliar no aprendizado.

As pesquisas aqui apresentadas nos convidam a ir além do pânico moral ou da negação da tecnologia. Elas apontam para a IA como uma ameaça à avaliação tradicional, sim, mas também como um estímulo para a inovação em avaliação.

É nesse contexto que o papel do educador se reafirma como central e insubstituível. Nenhuma ferramenta de IA, por mais sofisticada que seja, pode substituir o julgamento pedagógico na hora de desenhar uma avaliação que esteja alinhada aos objetivos de aprendizagem, que seja justa para todos os estudantes em sua diversidade e que sirva como uma experiência de aprendizado em si. A decisão sobre o quê, porquê e como avaliar, continua sendo (ou deveria ser) uma tarefa eminentemente humana.

Conversando com meus alunos essa semana tive a sensação de que estamos nesse meio do caminho em que já temos bastante informação mas as definições ainda estão muito embaçadas. Que tenhamos regulamentação e, pra além disso, criatividade pra nos adaptarmos! Obrigada pelo texto e indicações de arquivos!

Boa tarde, excelente texto. Vou compartilhar na Universidade em que trabalho.