Reconhecimento facial na educação...para quê e para quem?

O uso desta tecnologia de Inteligência Artificial em ambientes educacionais acena para vigilância, controle, invasão de privacidade e segurança pessoal, entre outros riscos

Bem-vindos a mais uma edição da IAEdPraxis, sua fonte de informação para explorar os caminhos da Inteligência Artificial aplicada à Educação.

Nesta semana deixamos a experimentação criativa de lado, para tratar de um assunto polêmico, associado a impactos danosos e potencialmente perigosos da tecnologia: o reconhecimento facial e sua utilização em escolas e universidades.

IA em Foco

Por Marcelo Sabbatini

Durante o seminário "Inteligência Artificial e Caminhos da Educação" promovido em junho de 2024 pela Fundação Joaquim Nabuco, o professor Sérgio Amadeu contou sobre seu conflito com o condomínio onde mora, ao exigir as chaves de portas de acesso e recusar cadastrar seu rosto para o reconhecimento facial. Estudioso da cibercultura, ativista do software livre e da democracia digital, seu posicionamento diante de um risco à privacidade é compreensível. Mas ele foi mais contundente, ao relacionar o reconhecimento facial com a educação: vai dar errado muito errado, mas muito errado mesmo.

Mas por quê? Ao contrário do ceticismo diante da eficácia de chatbots como o ChatGPT, o problema do reconhecimento facial é que ele funciona - talvez até bem de mais. Seria inclusive uma das aplicações de IA preditiva que os autores de "AI Snake Oil: What Artificial Intelligence Can Do, What It Can’t, and How to Tell the Difference" (Óleo de Cobra da IA: O que a Inteligência Artificial Pode Fazer, O que Não Pode, e Como Distinguir a Diferença, em tradução livre, de Arvind Narayanan e Sayash Kapoor), recentemente resenhado aqui em nossa newsletter, apontam como uma combinação perigosa: que funciona do ponto de vista tecnológico, mas que pode ter impactos destrutivos para a vida das pessoas.

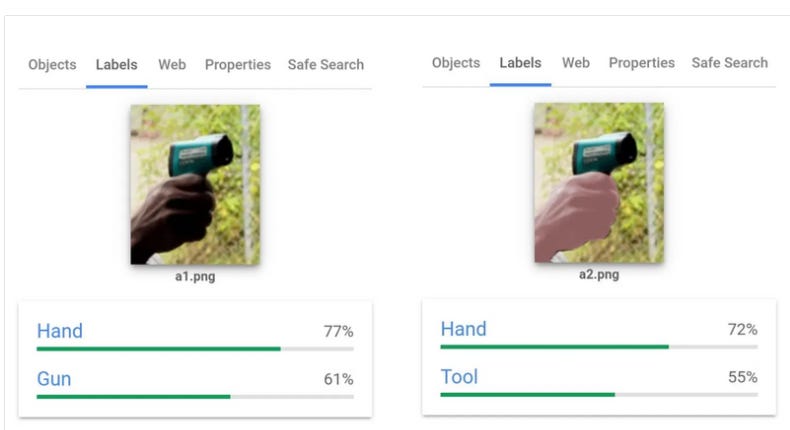

No âmbito da relação tecnologia e sociedade de forma mais ampla, este perigo tem sido amplamente criticado, a partir do prisma da privacidade. Não somente a tecnologia abre a possibilidade de uma tecnovigilância sem precedentes na História humana, como é sujeita a vieses. Entre muitos autores, Shoshana Zuboff no panorama internacional e Tarcízio Silva no Brasil, com seu trabalho sobre racismo algorítmico, alertam para estes riscos.

Entretanto, o reconhecimento facial por IA faz parte cada vez mais de nosso cotidiano. Anteriormente considerado "alta tecnologia", como muitas vezes retratado no cinema, na atualidade uma parcela considerável de instituições que de uma forma e outra limitam o acesso e a circulação (por exemplo um condomínio de classe média alta) já contam com ela.

Recentemente, o Restaurante Universitário da Universidade Federal de Pernambuco adotou o sistema, capturando dados biométricos de identificação de todo um contingente populacional que por sua própria natureza é associado a movimentos ético-políticos. O que um governo autoritário poderia fazer com este conjunto de dados, em termos de controle social e de vigilância?

Como no debate mais geral sobre a Inteligência Artificial, o campo educacional não é imune à tecnologia do reconhecimento facial; pelo contrário, ela tem sido colocada como "solução" de problemas que não são bem definidos, mas que correspondem a uma certa concepção de educação.

Assim, nas eleições municipais do Recife de 2020, o candidato de extrema-direita propunha sua implementação, nestes termos:

Usaremos tecnologia para a leitura facial dos alunos nas escolas, através de um sistema com alimentação em tempo real, possibilitando ainda fazer a chamada, lançar os boletins, organizar as agendas e grades de aula, fazer os registros de classe (...) os resultados poderão ser analisados e monitorados de forma muito mais assertiva pela gestão e pelos pais, tudo na palma da mão.

Na superfície e de acordo com a perspectiva gerencial acima, poderia se argumentar que o reconhecimento facial nas escolas e outras instituições educacionais atende a objetivos legítimos, a exemplo de:

Segurança, com o controle de acesso de pessoas autorizadas como professores, estudantes, funcionários.

Automação de tarefas administrativas, "liberando" os professores para atendimento aos alunos.

Disciplina, com o registro automático da presença dos estudantes nas dependências da escola e agindo contra a evasão.

Detecção de riscos de violência, a partir da análise de emoções a partir de expressões faciais e cruzamento com outros dados como postagens em redes sociais.

Analítica de dados, com a detecção de padrões relacionados ao desempenho acadêmico.

Essas aplicações, por si só, dão vazão a uma série de questionamentos em relação à privacidade e segurança de dados pessoais. E ainda mais quando, em sua grande parte, envolvem menores de idade. Se em termos gerais o vazamento desses dados pode ser usado para roubo de identidade, fraude e outras atividades maliciosas, na questão infantil podemos contemplar problemas ainda mais graves.

Porém, o impacto desta tecnologia também seria interno, através de suas intencionalidades não explícitas e de seus valores embutidos, intrínsecos. Neil Selwyn, analista "desconfiado" da tecnologia social já argumentava em 2019, juntamente com Andrevic, sobre como a concepção de escolarização poderia ser impactada, com a incorporação de vieses autoritários e de uma cultura de vigilância. Em sua análise, apesar do discurso em torno de sua “eficiência” e “valor agregado”, sua adoção basicamente responderia a questões de controle e de poder.

Tais riscos podem facilmente ser prejudiciais e assim o reconhecimento facial na educação pode atender aos três tipos de danos, caracterizados num estudo recente. Em primeiro lugar, os "danos de qualidade de serviço", conforme o sistema tecnológico falha, incapaz de atuar e forma consistente e padronizada. Como exemplo, sistemas de reconhecimento facial têm falhado sistematicamente em reconhecer estudantes negros.

Este falha em particular logo se relaciona aos "danos representacionais", isto é, tentativa de categorizar estatisticamente características sociais complexas. Assim, o comportamento dos estudantes, suas estórias de vida, comportamentos e origens são condicionados a categorias hierárquicas pré-estabelecidas, frequentemente discriminatórias.

Finalmente, os "danos interpessoais" dizem respeito ao impacto das relações dentro do contexto educacional, especialmente através do estabelecimento de uma cultura de vigilância algorítmica.

Particularmente, o reconhecimento facial aliado à análise de emoções compõe uma ciência ainda duvidosa, principalmente se considerarmos a falta de transparência dos algoritmos utilizados.

Dito de outra forma e exemplificando, a leitura que o sistema faz de uma expressão facial não necessariamente corresponde a um estado emocional. Como consequência, inferências sobre níveis de atenção, motivação e participação também são questionáveis.

Quais dados foram utilizados para a aprendizagem de máquina? Quais são possíveis vieses incorporados? Qual o rigor metodológico das pesquisas que embasam os algoritmos? Como geralmente trata-se de tecnologia proprietária, cujos detalhes de funcionamento interno não são divulgados, esta aplicação da IA Preditiva poderia ser classificada como "banha de cobra". Isto é, como um remédio milagroso, mas que não funciona na prática.

Voltando um pouco à teorização, este é o tipo de "solução educacional" que se ampara no imaginário social (segurança, eficiência) de uma ideologia que está por trás. Este "dataísmo", segundo o termo do pesquisador das Ciências da Comunicação Jan Van Djik, assume que dados, como as expressões faciais, são naturais e correspondem a natureza objetiva da realidade. Não são!

Em sua análise, McStay questiona a validade científica e a precisão dos sistemas de reconhecimento facial, particularmente aqueles baseados na teoria das "Emoções Básicas". Tanto a diversidade cultura nas expressões faciais, como a complexidade das emoções humanas não podem, até o momento, serem capturadas por um conjunto limitado de categorias. É mais, a tecnologia pode impactar a construção da identidade e a expressão autêntica de emoções, limitando a espontaneidade e a individualidade. Somando a preocupação ética, incluindo a necessidade de consentimento informado e livre dos alunos e seus responsáveis, este tipo de aplicação também esbarra em leis de proteção de dados e os direitos da criança. Portanto, seria incompatível com valores sociais e com o entendimento da educação como bem público.

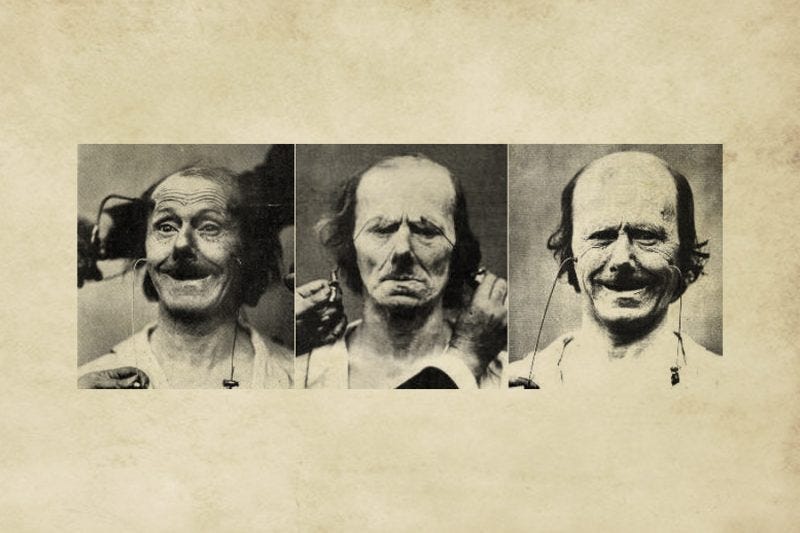

A natureza subjetiva da interpretação das emoções foi demonstrada através de um experimento de edição, quando a tecnologia e a linguagem do cinema ainda eram novas. Tristeza? Fome? Desejo sexual? A mesma expressão é "lida" de forma diferente, se considerarmos o contexto mais amplo, isto é com interação de dois fotogramas, em contraposição à imagem isolada.

O efeito Kuleshov, batizado em função do cineasta russo que o descobriu com suas experimentações na década de 1920, estipula que o sentido é derivado do contexto.

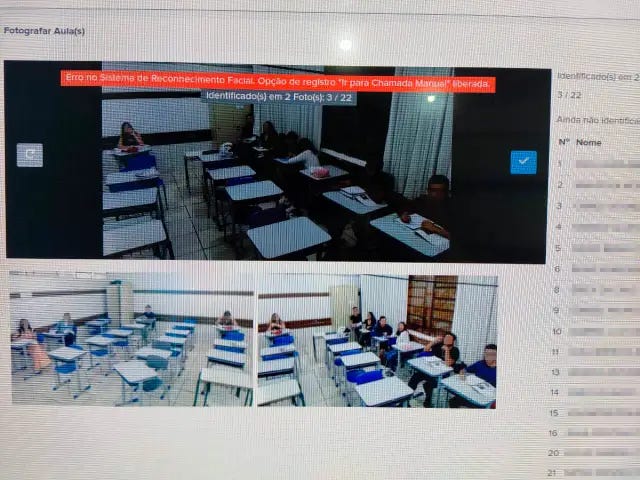

Além disso, e como Selwyn argumentou mais recentemente, podemos perceber uma tendência de modificar a educação diante das necessidades da IA. Esta intervenção tecnológica reorganiza o pedagógico em termos de padronização, homogeneização e perda da autonomia. É a sala de aula que se organiza de forma a ser "legível pela máquina", produzindo dados que vão alimentar o sistema.

Nos termos do filósofo da tecnologia Langdon Winner, trata-se da "adaptação reversa". Professores passam a adotar uma didática que possa ser facilmente codificada pelo sistema de reconhecimento. Professores e alunos adotam "atos performativos algorítmicos" vazios de significado, a exemplo de utilizarem determinadas expressões e gestos que possam aumentar suas métricas de empatia.

Entretanto, estes questionamentos não têm sido capazes de impedir a implementação do reconhecimento facial na educação brasileira. Como caso exemplar, as escolas estaduais do Estado do Paraná atualmente utilizam a tecnologia para controlar não somente alunos, mas professores. Associado a uma concepção pedagógica de padronização, o resultado é um monitoramento constante, com a perda de tudo o que uma sala de aula pode ter de criativo e de humano.

Diante de tudo isso, as questões éticas e as preocupações sobre privacidade e controle social apontam para um sonoro "não" em relação ao uso de reconhecimento facial no campo educacional. Como educadores, precisamos estar atentos para os riscos, participar dos debates públicos em relação a direitos humanos fundamentais e à concepção de educação que desejamos.

Voltando a algo que Sérgio Amadeu disse em seu seminário, não podemos deixar de discutir as implicações de sistemas automatizados, de coisas que não precisariam ser automatizadas, para início de conversa. E isso implica assumir um posicionamento de resistência e exigir a chave do portão, metaforicamente.

Sua voz é fundamental para enriquecer este diálogo. Sinta-se à vontade para nos enviar suas observações, histórias ou questionamentos através de qualquer um de nossos canais.