Inteligência Artificial, mais uma charlatanice na história das tecnologias?

Como a banha de cobra, IA não é solução para tudo e pode nem funcionar, especialmente na Educação

Bem-vindos a mais uma edição da IAEdPraxis, sua fonte de informação para explorar os caminhos da Inteligência Artificial aplicada à Educação. Esta semana vamos examinar o que se esconde entre as promessas e os limites da IA, a partir da resenha de um livro lançado por uma das vozes mais influentes no assuntol

IA em Foco

Por Marcelo Sabbatini

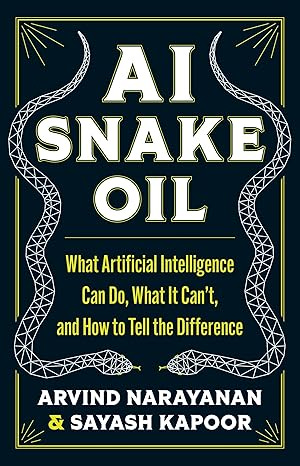

Recentemente lançado, "AI Snake Oil: What Artificial Intelligence Can Do, What It Can’t, and How to Tell the Difference" (Óleo de Cobra da IA: O que a Inteligência Artificial Pode Fazer, O que Não Pode, e Como Distinguir a Diferença, em tradução livre) de Arvind Narayanan e Sayash Kapoor busca desafiar o discurso dominante da Inteligência Artificial como a grande solução dos problemas modernos. Utilizando o mote da "banha de cobra" tecnológica, remédios milagrosos que falham em cumprir o que anunciam e podem inclusive causar dano, os autores buscam mostrar como o exagero, a falta de criticidade e mesmo a desinformação poderão nos trazer graves consequências preocupantes.

Considerado pela revista Times uma das cem vozes mais influentes no debate sobre AI, Arvind Narayanan é professor da Universidade de Princeton. Já seu co-autor é seu orientando. Juntos, ambos mantém uma newsletter, com uma orientação um tanto mais técnica, mas ainda questionando os limites da tecnologia.

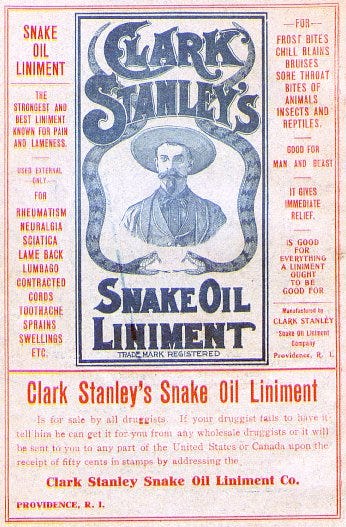

Um pouco sobre a metáfora

Antes da resenha propriamente dita, algumas palavras sobre a expressão que aparece no título e que guia a argumentação dos autores. O "óleo de cobra", se traduzido literalmente, refere-se aos unguentos a base de óleo mineral que costumavam ser vendidos como "cura tudo" no século XIX e início do século XX, nos Estados Unidos. A imagem é comum em filmes de far-west e, atualmente, a expressão se tornou um eufemismo para significar marketing enganoso e fraude.

Contudo, ao pesquisar um equivalente para a expressão, encontrei que em Portugal existe o termo "banha de cobra", com o mesmo sentido. Vendida em feira populares, mas com pouca eficácia, a expressão também se aplica a diversas situações nas quais há muita propaganda, mas pouco efeito, incluindo debates de natureza política. Neste texto irei utilizar as duas expressões de forma intercambiável.

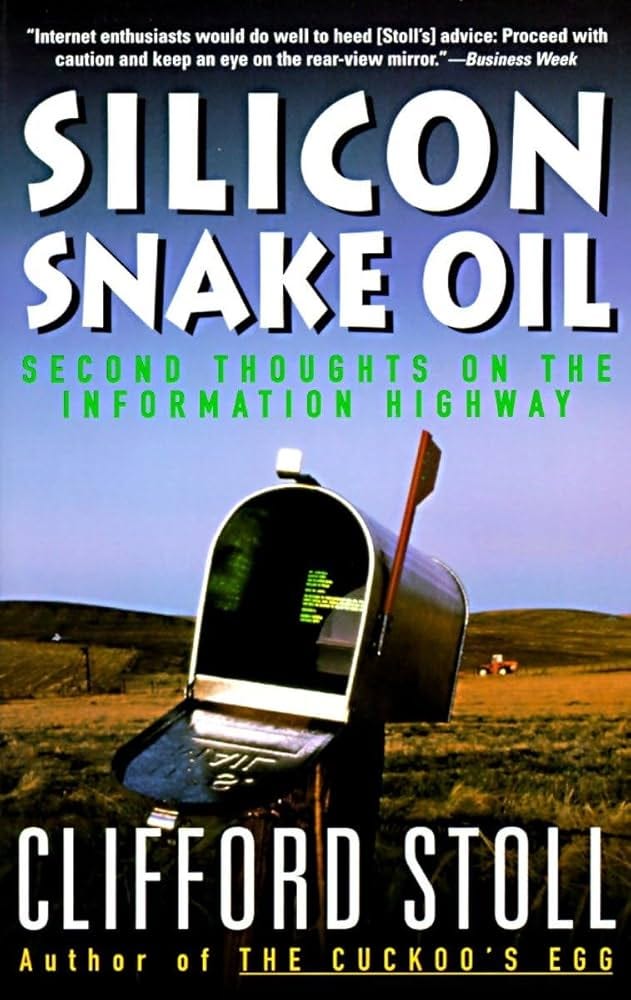

Finalmente, preciso registrar que Narayanan e Kapoor parecem ter incorrido numa de duas falhas: ignorância ou indelicadeza e falta de atribuição. Comento isso por que em 1995 1990 a obra "Silicon Snake Oil: Second Thoughts on the Information Highway" (Óleo de Cobra de Silício: Reflexões sobre a Super-Rodovia da Informação) de Clifford Stoll já utilizava a mesma metáfora para questionar a Internet como um fenômeno sobrevalorizado. Uma tese que envelheceu mal, diga-se de passagem e foi considerada um erro pelo autor.

Mas ao não citarem este livro fica a impressão ou de que os autores desconhecem uma obra importante sobre a avaliação crítica das tecnologias ou que não quiseram reconhecer que a figura já tinha sido utilizada anteriormente.

Principais pontos

Em sua utilização, os autores definem o "óleo de cobra de IA" como aquela Inteligência Artificial incapaz de funcionar como anunciada. Dito de outra forma, é uma tecnologia que não corresponde ao discurso inflado que temos observado nos últimos tempos.

Contudo, conforme a Inteligência Artificial se refere a um amplo conjunto de aplicações, a consequência seria a de que a maior parte de nós ainda não somos capazes de distinguir o que é "óleo de cobra" e o que não é. Diante deste dilema social, com a necessidade de discernimento e da tomada de medidas de proteção contra possíveis danos, o livro se propõe como guia de identificação dos enganos das afirmações e entusiasmo exagerado ("hype"). Porém, há muitos casos em que a linha entre uma e outra ainda é difusa.

O dilema é agravado pelo fato da IA ter se tornado, em curto espaço de tempo, um produto generalizado de consumo público. "É como se tivessem dado a todas pessoas no mundo, simultaneamente, o equivalente a uma serra elétrica grátis". Com isso, carecemos de um vocabulário básico e de maneiras de avaliar a plausabilidade do que a IA promete. E mais, carecemos de compreensão dos vários tipos de IA disponíveis, ainda que o termo guarda-chuva se aplique a tecnologias muito diferentes entre si.

Tipos de IA: quando e como usá-las

Dito, isso os autores tratam logo de estabelecer as conceituações necessárias para o debate.

IA Generativa

O tipo que tem chamado a atenção do público desde o lançamento do ChatGPT, com sua capacidade de "criar" coisas. Nas palavras dos autores, "ainda é imatura, pouco confiável e suscetível a mau uso". Além disso, sua popularização tem sido acompanhada de exagero, medo e desinformação.

Apesar destes pontos negativos, Narayanan e Kapoor reconhecem que possuem um potencial de utilidade para toda ação humana dependente do conhecimento (educação inclusive). Exigindo uma certa curva de aprendizagem para seu uso, além de prática, é classificada no livro como uma tecnologia de "dois gumes". Mas não necessariamente "banha de cobra", como uma outra classe de Inteligência Artificial, de maior risco.

IA Preditiva

Compartilhando a designação "Inteligência Artificial", porém desenvolvida a partir de outros pilares, este tipo de IA tem como característica principal realizar previsões em relação ao futuro. Apesar de uma notável capacidade de identificação de padrões em grandes conjuntos de dados, seu uso geralmente é extrapolado.

E neste ponto os autores estabelecem um dos principais argumentos que irão desenvolver ao longo do livro: a IA Preditiva é "óleo de cobra", possivelmente nunca irá funcionar como o anunciado. O motivo, a dificuldade inerente de se prever o comportamento social humano; este não deveria ser um problema tecnológico, em primeiro lugar, ainda mais considerando a forma como pode afetar a vida das pessoas.

"Uma alegação extraordinária que exige prova extraordinária", a IA Preditiva tem seu atrativo na promessa de automação e de tornar os processos de tomada de decisão mais eficientes. Entretanto, a falta de responsabilização é consequência desta busca por eficiência.

Ao longo do livro, os autores irão apresentar diversos exemplos, e ainda mais, "estórias de terror" sobre pessoas que tiveram suas vidas alteradas por decisões baseadas em IA no campo da saúde, da justiça, do trabalho e das finanças.

Mas é na educação que os autores trazem um exemplo contundente, com o relato da aplicação de um software chamado EAB Navigate capaz de prever quais alunos teriam maior possibilidade de evadirem seus cursos. Contudo, ao invés de utilizá-lo para detectar estudantes em situação de risco e proporcionar intervenções de apoio adicional, é colocado o caso da instituição que iria usar a informação obtida para expulsar ou forçar o abandono destes estudantes, com isso elevando suas taxas de retenção.

E mesmo com uma atitude mais positiva, os resultados deste tipo de previsão do comportamento ainda seriam questionáveis. A recomendação de cursos alternativos, nos quais um estudante teria mais probabilidade de ter êxito acadêmico, afastaria alunos das classes menos favorecidas em direção a graduações de menor prestígio e empregabilidade, argumentam os autores.

Mapeando o poder da IA

Como parte de seu argumento a respeito da natureza "banha de cobra" da IA, o livro traz um gráfico no qual estão situados o "potencial de dano" e a "natureza de ser verdadeiro" como eixos.

Mesmo quando uma tecnologia de IA funciona bem, ela poder ser prejudicial às pessoas e à sociedade. O exemplo paradigmático dos autores é a tecnologia de reconhecimento facial. Bastante precisa, ela se torna prejudicial devido ao mau uso por seus operadores humanos, em termos de falhas de investigação policial e dados pobres (fotos borradas, com poucos detalhes). Mas é justamente sua precisão que a torna uma ferramenta de vigilância de massa extremamente perigosa, do ponto de vista político.

Origens do "hype"

Para compreender o poder de sedução do "óleo de cobra", os autores olham para dentro de seu "vórtice, buscando suas origens. E são claros, tanto pesquisadores acadêmicos, como as empresas e a mídia contribuem.

No terreno da pesquisa, citam como muitos estudos são afligidos de erros básicos metodológicos, principalmente quando a aprendizagem de máquina de é utilizada por pesquisadores sem experiência ou formação em ciências de dados. Uma armadilha comum neste sentido é o "vazamento de dados". Explicando, uma ferramenta é avaliada através dos mesmos dados nos quais ela foi treinada, levando a um inflacionamento de sua precisão. Quando testadas contra dados do mundo real, entretanto, sua capacidade diminui consideravelmente, ao ponto de não ser utilizável.

O problema, como argumentado, é que ao contrário de outros campos a ciência da IA tem falhado em se autocorrigir. As proposições incorretas dos artigos científicos acabam chegando ao mercado através de produtos "banha de cobra". Em meio a um mar de desinformação, a compreensão pública da IA sofre, especialmente quando os próprios pesquisadores se tornam porta-vozes do "hype".

Por sua vez, as empresas naturalmente irão exagerar o discurso acerca dos poderes de seus produtos, somando ao poder retórico seu poder econômico. Reações como a da U.S. Federal Trade Commission (FTC), agência independente do governo dos Estados Unidos que tem como missão proteger os consumidores e promover a concorrência ainda são tímidas. Em 2023, a FTC alertou o setor de que suas alegações seriam consideradas enganosas, caso carecessem de evidência científica ou fossem aplicáveis a casos muito particulares e limitados.

Finalmente, a mídia tem sua parcela de contribuição, ao reverberar as supostas realizações das empresas de IA, praticando o "jornalismo de acesso".

Diante da falta de criticidade, vemos iniciativas como do Centro Pulitzer, financiando o jornalismo investigativo sobre tecnologias de predição e vigilância com alto poder de impacto sobre políticas públicas, saúde, bem-estar social, sistema judiciário e trabalho.

Um exemplo, e retornando ao tema específico da educação, foi a reportagem de Ari Sen e Derêka K. Bennett do Dallas Morning News sobre o Social Sentinel. Esta tecnologia é anunciada como solução para a violência escolar, ao prever ataques a partir da análise das postagens em mídias sociais dos alunos; entretanto, como o trabalho jornalístico revelou, ela foi usada pera monitorar o protesto de estudantes.

Para onde vamos?

Apesar do atual estado de exagero, principalmente em relação à IA preditiva, Narayanan e Kapoor acreditam que a Inteligência Artificial irá desempenhar um papel importante no futuro, exigindo um processo de integração, em mudanças estruturais e de ajustes políticos e sociais.

Para o campo educacional, particularmente, afirma:

Sejamos claros — a IA não representa uma ameaça à educação, assim como a introdução da calculadora não o foi. Com supervisão adequada, ela pode ser uma ferramenta de aprendizado valiosa. Mas, para isso, os professores terão que reformular o currículo, suas estratégias de ensino e suas avaliações. Numa instituição bem financiada, como Princeton, onde ensinamos, isso é uma oportunidade, e não um desafio.

Mas especificamente, o "óleo de cobra de IA" é sedutor para "instituições quebradas e desesperadas por um conserto rápido". Em suas palavras, os professores já sobrecarregados de trabalho reagiram mal à disrupção das tarefas de casa geradas automaticamente. Porém, ao invés de reformular completamente sua concepção de ensino e de avaliação, o setor educacional tem se voltado para softwares de detecção de fraude. Estes, como muitas IA Preditivas, não funcionam e ainda podem trazer consequências irreversíveis para os alunos acusados. Palavra dos autores.

Com isso, argumentam que um possível caminho é focar na demanda do que realmente precisamos, mais do que na oferta de soluções para problemas imaginários. Posicionando-se contra o solucionismo tecnológico, reconhecem que todas as preocupações demonstradas em relação à IA, são em realidade, sobre o capitalismo.

Com isso, concluem pela necessidade de um "debate democrático vigoroso", tendo como objetivo identificar quais são usos apropriados, resistir aqueles que não o são e desenvolver mecanismos de segurança para prevenir uso indevidos.

Momento de Reflexão

A parte do argumento central do livro, Narayanan e Kapoor trazem uma definição curiosa de IA: "tudo aquilo que ainda não foi feito". Dito de outra forma, uma vez que uma tecnologia se torna suficientemente confiável, ela desaparece no cotidiano das pessoas e não é mais pensada como sendo Inteligência Artificial. Torna-se tecnologia invisível, ainda que os autores não utilizem este conceito da filosofia da tecnologia.

Um exemplo, o famoso aplicativo de rotas de trânsito lhe inspira a mesma reação de desconfiança que o ChatGPT? Se no futuro os chatbots estiverem tão integrados à nossa experiência cotidiana, ainda vamos nos referir a eles como IA?