Bem-vindos a mais uma edição da IAEdPraxis, sua fonte de informação para explorar os caminhos da Inteligência Artificial aplicada à Educação. Esta semana iniciamos uma série sobre o principal elemento interação com uma IA Generativa, o prompt. Começamos analisando seus tipos, partes e finalidades, além de estratégias para obter respostas e resultados mais precisos.

IA em Foco

Por Marcelo Sabbatini

No leito de morte de Gertrude Stein, sua companheira Alice Toklas perguntou: "Qual é a resposta?" Stein respondeu: "Qual é a pergunta?" — e essas foram suas últimas palavras. Esta anedota ilustra a importância de formular a pergunta certa. Na era da Inteligência Artificial ela se traduz na constatação de que a qualidade da resposta depende diretamente da precisão do prompt, isto é, da instrução textual proporcionada à máquina.

Em termos da evolução dos sistemas de Inteligência Artificial, o prompt é um diferencial, ao utilizar linguagem natural. Ou seja, não demanda conhecimento técnico especializado, com o uso de árvores de decisão e comandos de programação. A partir de uma "conversa", comportamentos complexos da IA são acionados, eliminando as barreiras técnicas entre intenção humana e a execução computacional.

Contudo, ainda hoje, elaborar um prompt é um processo iterativo de experimentação, análise e ajuste. O ponto de equilíbrio entre o que o usuário realmente necessita e o resultado do processamento autônomo da IA passa pelo conhecimento de alguns conceitos, além de algumas técnicas.

Compreendendo prompts

Dada a natureza probabilística das respostas da IA Generativa, a instrução ou pergunta fornecida — prompt — é responsável por grande parte da qualidade, relevância e utilidade da resposta. Certos cuidados em sua formulação evitam respostas genéricas e gere algo mais específico.

Exemplo: você pode pedir que a IA explique determinado conceito científico. Mas ao acrescentar a delimitação "para um estudante de Ensino Médio", a resposta assume outra dimensão de tratamento e profundidade.

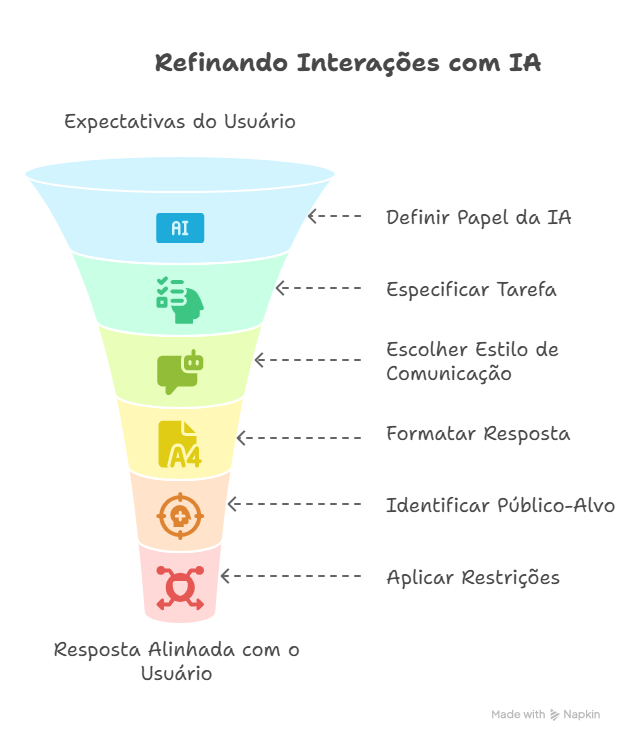

Assim, a elaboração do prompt influencia aspectos como:

Precisão, com redução de ambiguidades e interpretações errôneas.

Relevância, mantendo a IA focada no tema central.

Profundidade, com análises mais elaboradas.

Criatividade, estimulando inovação e o fora do comum.

Formato, determinando a estrutura e o estilo da resposta.

Engenharia de prompts?

Anunciada como a "profissão do futuro" a partir do surgimento do ChatGPT, esta prática envolve "o processo de desenhar prompts de alta qualidade que guiam os LLMs para produzir respostas precisas", na definição do guia "Prompt Engineering", de Lee Boonstra, publicado pelo Google em 2024.

Para além de simplesmente escrever as instruções, o termo "engenharia" também faz alusão à manipulação de parâmetros técnicos que influenciam o comportamento dos modelos de IA.

Na atualidade, porém, há ressalvas em relação a esta ser efetivamente uma área do conhecimento ou a se configurar como uma profissão propriamente dita.

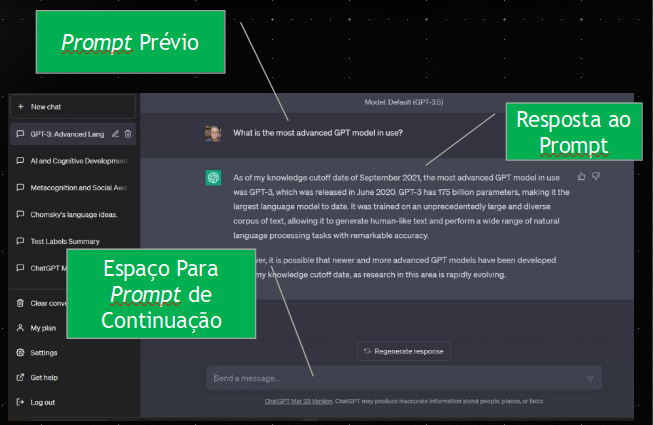

Anatomia de um prompt

O uso da linguagem natural para a interação com as IAs Generativas, apesar de democratizar e facilitar o acesso, também acaba ocultando uma certa complexidade e a necessidade de precisão na formulação dos prompts. Nesse sentido,

Você não precisa ser um cientista de dados ou um engenheiro de aprendizagem de máquina - qualquer pessoa pode escrever um prompt. Porém, criar o prompt mais eficaz pode ser complicado. Muitos aspectos do prompt afetam sua eficácia: o modelo utilizado, suas configurações, a escolha de palavras, estilo e tom, estrutura e contexto, todos são importantes (Lee Boonstra).

Dito isso, classicamente um prompt se classifica segundo seus componentes essenciais. Na formulação de Rafael Sampaio, em seu guia de prompts acadêmicos eles são:

Papel (ou persona), atribuindo uma personalidade à IA, a exemplo de um especialista ou profissional específico, tornando as respostas mais consistentes com as expectativas da área de conhecimento.

Tarefa/Contexto, definindo o que se deseja obter (resumo, análise, comparativo) e incluindo o contexto específico da pesquisa para direcionar adequadamente a resposta.

Estilo, especificando o tom desejado (objetivo, didático, formal, acessível) para que a IA adéque a forma de exposição ao propósito do texto.

Formato, estabelecendo limites de extensão, estrutura do texto ou tipo de resposta (lista, texto corrido, tabela).

Público-alvo, definindo para quem o texto se destina, o grau de complexidade é calibrado, com nível de detalhe e terminologia adequados aos leitores.

A estes, outros guias e orientações acrescentam:

Restrições, estabelecendo diretrizes específicas sobre o que não deve ser incluído ou o que deve ser evitado (por exemplo, não usar determinadas fontes, evitar posicionamentos políticos, ou manter-se dentro de marcos teóricos específicos).

Exemplos, evidenciando modelos ou amostras do tipo de resposta esperada, referências para orientar o estilo, estrutura e qualidade da resposta desejada.

Estes componentes podem ser vistos na prática, em nossa biblioteca de prompts.

Papéis ainda são necessários?

Até pouco tempo atrás, havia uma recomendação básica: fornecer a IA um papel, para contextualização. Como nos explica Ethan Mollick, em seu livro "Co-Intelligence: living and working with AI":

A evolução dos chatbots e, principalmente os modelos de linguagem com capacidades de raciocínio parecem tornar desnecessária esta precaução. A exceção se dá quando o papel demanda alguma caracterização adicional, que influencie a resposta.

Exemplificando: não seria mais preciso dizer à IA que ela deva assumir o papel de um professor que irá avaliar seu projeto de pesquisa em elaboração. Mas acrescentar características como "arrogante, que realiza observações ácidas e excessivamente críticas" configura-se um objetivo diferente.

Conceitos relacionados

Antes de entrarmos nas características e passos para elaborar um prompt, pode ser interessante esclarecer alguns conceitos envolvidos.

A começar pelo funcionamento dos grandes modelos de linguagem (LLMs), que basicamente são máquinas de realizar previsões. Isto significa que o modelo toma uma sequência de texto como entrada e em seguida prevê qual seria o próximo token (uma unidade básica de texto), com base em seu treinamento. Em seguida, a partir do token escolhido e acrescentado à cadeia, prevê o próximo. Este processo se repete, algo que podemos inclusive visualizar no funcionamento dos chatbots.

Considerando que um token pode ser uma palavra, parte de uma palavra ou mesmo um caractere individual, sua quantidade influencia diretamente a complexidade e extensão das respostas possíveis, assim como o custo computacional de processamento.

Modelos mais avançados como o Gemini 2.5 possuem janelas de token gigantescas, isto é, capacidade de processar e manter em memória uma quantidade maior de texto de entrada, permitindo trabalhar com documentos extensos, múltiplas fontes simultaneamente e manter o contexto de conversas longas.

Tipos de prompt

Também buscando uma melhor utilização, os prompts podem ser categorizados, segundo Boonstra, em:

Zero shot, a forma mais simples, consiste apenas na descrição de uma tarefa. Esta entrada textual pode assumir várias formas, como uma pergunta, o início de uma estória ou um conjunto de instruções propriamente ditas. O "zero" de seu nome se refere a "sem exemplos".

One-shot e few-shot, incluem exemplos que ajudam o modelo de IA compreender o que está sendo solicitado. Exemplificar é particularmente útil quando um certo padrão ou estrutura é buscado na resposta.

Com nome autoexplicativo, o one-shot utiliza um único exemplo que a IA deve imitar ao máximo na execução da tarefa. Por sua vez o few shot proporciona múltiplos exemplos, estabelecendo um padrão a ser seguido.

Prompt contextual, proporciona detalhes específicos e relevantes para a tarefa em questão. Auxilia o modelo a compreender as nuances do que está sendo solicitado.

Prompt de papel, atribui um personagem ou identidade à IA, o que auxilia na geração das respostas. Também pode delimitar o estilo e voz do texto de saída, acrescentando uma camada de especificidade e personalidade.

Engenharia automática de prompt, método que reduz a intervenção humana, usando um prompt para escrever prompts, num processo iterativo de avaliação, ajuste e nova geração. Abordamos esta técnica, sob a denominação meta-prompt.

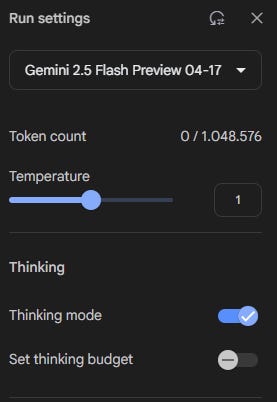

Parâmetros

A maioria dos chatbots — ChatGPT, Claude, Gemini — utilizam uma interface transparente e simplificada ao usuário, facilitando sua utilização. Contudo, qualquer Grande Modelo de Linguagem possui parâmetros de configuração adicionais que podem ser evocados por meio de interface (por exemplo, no IA Studio) ou diretamente, explícitos no prompt.

Temperatura, controla o grau de aleatoriedade ou "criatividade" nas respostas, regula a imprevisibilidade do modelo.

Temperatura baixa (próxima a 0) proporciona respostas mais previsíveis e conservadoras. Útil para tarefas que exigem precisão, como resolução de problemas matemáticos. Aqui o comportamento é determinístico, o token de maior probabilidade será sempre escolhido.

Temperatura alta (próxima a 1), gera respostas mais diversas e potencialmente criativas. Ideal para chuva de ideias e conteúdo visual.

Penalidade de frequência, desencoraja a repetição excessiva de palavras ou frases. Ao ajustar este valor, o usuário pode:

Aumentar a diversidade do vocabulário nas respostas

Evitar padrões repetitivos no texto gerado

Melhorar a fluência e naturalidade das respostas

Penalidade de presença, similar ao anterior, mas focada em evitar a repetição de temas ou ideias, não apenas palavras específicas. Útil para:

Gerar conteúdo mais diversificado e abrangente

Evitar que a IA fique "presa" em determinado tópico ou perspectiva

A utilização destes parâmetros permite um controle mais preciso sobre as saídas da IA, segundo o contexto. Por exemplo, um professor pode usar uma temperatura mais baixa ao gerar explicações técnicas, mas aumentá-la ao solicitar ideias criativas para projetos.

Sobre "truques" e "macetes"

A variabilidade da resposta dos chats de IA, incluindo sua imprevisibilidade e tendência a erros e invenções (alucinações) levou a comunidade de usuários a testar e experimentar toda uma série de recomendações, em busca de melhores resultados.

Alguns refletem os mecanismos internos de funcionamento do modelo ("você será penalizado se..."), enquanto outros são empíricos e aparentemente inexplicáveis ("Vou dar uma gorjeta $x para uma solução melhor!").

Tem também aqueles que não fazem muito sentido e possivelmente não alteram os resultados ("Repita uma palavra ou frase específica várias vezes em um prompt", "Use comandos positivos como "fazer" e evite palavras negativas como "não").

Por outro lado, algumas práticas ajudam o usuário a organizar seu próprio pensamento e talvez não tenham efeito sobre IA:

Formatar o prompt, delimitando com sinais gráficos (## ou //) cada um de seus elementos. Ao mesmo tempo, utilizar quebras de linha para separar instruções, exemplos, perguntas, contexto e dados de entrada.

Estabelecer uma conversa, com perguntas e respostas, antes de pedir a tarefa propriamente dita.

Finalmente, outras dessas recomendações configuram técnicas mais avançadas, que trataremos numa segunda parte deste artigo:

"Divida tarefas complexas em uma sequência de prompts mais simples em uma conversa interativa" >> Decomposição de tarefas

"Use palavras importantes como escrever "pense passo a passo" >> Cadeia de pensamento

"Para escrever um texto semelhante a uma amostra, inclua esta instrução: Use o mesmo estilo de linguagem do parágrafo/título/texto/ensaio/resposta fornecido" >> Treinamento

Um pensamento: com tantas recomendações, acrescidas da necessidade de testar, ajustar, voltar a testar, encontramos um paradoxo: o tempo de escrever um prompt pode ser superior ao de realizar a tarefa por conta própria. Este é um dos fatores contribuem para explicar o porquê da IA Generativa ainda não ter produzido um aumento de produtividade no trabalho, segundo uma pesquisa divulgada recentemente.

Desafios

Apesar da evolução tecnológica, o prompt continua sendo a base da interação entre humanos e IA. Além de sua estrutura básica, o domínio do conteúdo específico associado a técnicas mais avançadas faz com que repositórios de prompts específicos para seus campos de interesse sejam valiosos e necessários.

Ao mesmo tempo, os desafios e limitações precisam ser considerados. A variabilidade nas respostas das IAs, mesmo com prompts idênticos, pode dificultar a consistência. Ao mesmo tempo, os vieses e preconceitos embutidos nos dados de treinamento das IAs podem se manifestar nas respostas, exigindo vigilância constante.

Com tudo isso, a formulação e reformulação de prompts continuará sendo uma competência exigida para um uso consistente da tecnologia. Em nossa próxima edição daremos continuidade ao tema, abordando técnicas avançadas de utilização de prompts. Fiquem ligados!