Algoritmos que dão nota?

Desafios e considerações sobre a Inteligência Artificial na avaliação educacional

Bem-vindos a mais uma edição da IAEdPraxis, sua fonte de informação para explorar os caminhos da Inteligência Artificial aplicada à Educação.

Esta semana vamos tratar de uma das mais anunciadas aplicações da Inteligência Artificial na educação: a avaliação.

IA em Foco

Por Marcelo Sabbatini

Joãozinho ansioso por sua nota na prova perguntou para a professora:

— Fêssora, a senhora já corrigiu as provas?

— Não, Joãozinho! Tenho várias turmas!

E a professora continua normalmente a aula:

— Turma, fizeram as tarefas de casa?

Imediatamente Joãozinho responde:

— Não! Temos vários professores!

Se tem piada, tem pelo menos um fundinho de verdade. Avaliar o desempenho dos alunos, mais além do trabalhoso "corrigir provas" sempre foi uma etapa desafiadora do processo pedagógico. Nesse ponto, embora a Inteligência Artificial seja anunciada como ferramenta "revolucionária" para a avaliação, é preciso debater antes questões fundamentais, a exemplo de o quê, como, quando e por quê avaliar. Estas perguntas, importante ressaltar, precisam ser definidas por nós, e não delegadas a uma tecnologia supostamente imparcial e objetiva.

Além disso é preciso considerar um aspecto mais delicado da avaliação. Através dela são aplicados os critérios de sucesso - ou de fracasso - acadêmico e toda hierarquização entre estes dois extremos. Dessa forma, surge a questão: podemos confiar em máquinas e permitir que elas influenciem decisões críticas sobre o progresso e o futuro acadêmico dos nossos alunos?

Antes desta retomada da IA, a automatização da avaliação já começava a ganhar espaço com o uso de tecnologias mais tradicionais, como softwares de correção automática de testes e sistemas de gestão de aprendizagem. Essas ferramentas em certa medida liberam os professores da correção de provas objetivas e facilitam a gestão das notas. Porém, também exigem um domínio instrumental e lhes atribuem tarefas-meio, antes responsabilidade da gestão escolar.

Além disso, o grau limitado de automatização necessariamente limita a avaliação a provas de múltipla escolha. Carece, assim, da capacidade de lidar com nuances e subjetividades presentes em formas mais complexas, como por exemplo redações e projetos.

Particularmente, corrigir textos e provas dissertativas exige julgamento subjetivo, envolvendo a análise do conteúdo, da estrutura argumentativa, da clareza e da originalidade, além da consideração de aspectos linguísticos e gramaticais. Para tornar mais complexo, o caráter subjetivo demanda consistência e imparcialidade, dependendo do avaliador.

Avaliar é, portanto, um esforço intelectual quer vai além do tempo exigido, uma carga de trabalho que limita a quantidade e a profundidade das correções possíveis.

Poderíamos dizer, inclusive, que com todos estes elementos, a avaliação é um empreendimento exclusivamente humano, ainda mais se considerarmos o retorno aos alunos, necessário para configurar um processo formativo. Ou pelo menos, era.

Possibilidades do uso de IA na avaliação

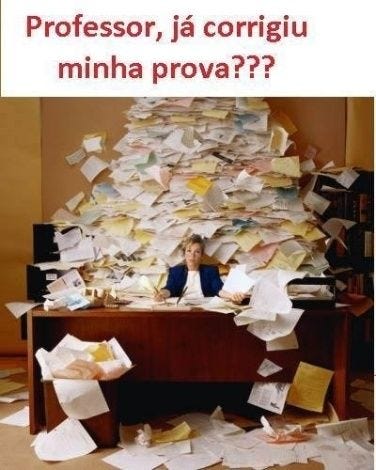

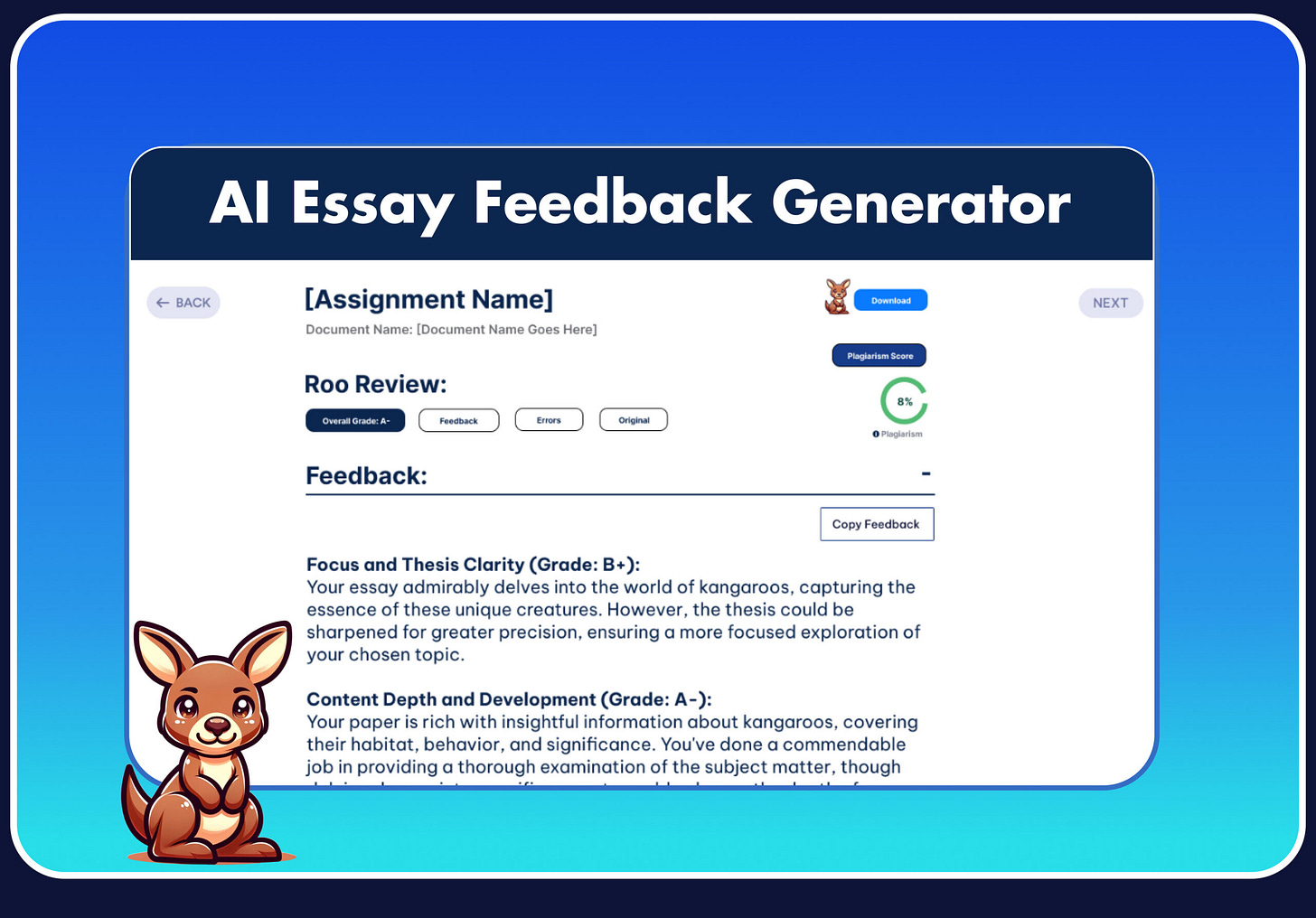

Os desenvolvimento recentes em IA acenam com um potencial de transformação desta realidade. Os algoritmos de processamento de linguagem natural são capazes de avaliar a estrutura de um texto, verificar a coerência dos argumentos e identificar erros gramaticais e de estilo com uma precisão que rivaliza com a de revisores humanos.

Com sua capacidade de reconhecer padrões, estes sistemas podem atribuir notas consistentes, com base em critérios predefinidos. Em termos de feedback, oferecem aos alunos correções e sugestões de melhorias: clareza, coesão, uso de vocabulário, conformidade com as regras gramaticais.

Tudo isso de forma instantânea, potencialmente extinguindo a clássica pergunta "professor, quando sai a nota?". Como exemplo, já em 2017 se pesquisava na China um “superprofessor” artificial capaz de corrigir 500 milhões de perguntas dos testes de Ensino Médio no país.

Contudo, a análise textual não se limita à avaliação, mas também ao processo de elaboração do texto. Progressivamente incorporadas a Ambientes Virtuais de Aprendizagem ou como ferramentas avulsas, as ferramentas de escrita assistida e revisão permitem aos alunos alcançar por conta própria um nível superior de qualidade, antes de enviar seus trabalhos.

Além disso, os sistemas de IA são capazes de fazer algo que o bom e velho revisor dos processadores de texto não faz: analisar a argumentação lógica e a estrutura narrativa dos textos. Coerência, presença de falácias, adequação e suporte aos argumentos estão presentes numa análise mais detalhada.

Também podemos pensar na abertura de possibilidades e inovações. Uma mudança qualitativa viria com novas formas de avaliação, realizadas de forma contínua, em tempo real, no momento em que a aprendizagem está ocorrendo. Em 2019, um projeto da University College de Londres visava aplicar este conceito e remover as pressões do formato de prova, também considerado insuficiente e inadequado por muitos especialistas do campo da avaliação educacional.

De qualquer forma, já é possível aplicar a IA na avaliação educacional a partir de um prompt relativamente simples, com o ChatGPT ou similares. Para sua plena utilização, entretanto, algumas considerações são necessárias.

Um olhar detalhado sobre os limites da avaliação com IA

Primeiro, a automatização do processo em si precisa ser automatizada. Exemplificando, para utilizar o ChatGPT com fins de avaliação, precisaria copiar e colar cada trabalho individualmente na janela de texto, logo transferir as respostas para uma mensagem de devolutiva para o aluno. Multiplicando pelo número de alunos numa turma, é tempo e trabalho repetitivo. Já uma plataforma de se comunicar diretamente com o ChatGPT (através de uma API, Interface de Programação de Aplicações) realizaria este processo de forma automática. Temos acesso a ferramentas assim? A que custo?

Logo, a eliminação do professor no processo (ou não), questão já debatida aqui na newsletter. Especificamente na avaliação, cabe perguntar: em que medida ela pode substituir o trabalho de professores? Totalmente? Parcialmente, como uma ferramenta de auxílio , mas sem eliminar o julgamento crítico e a sensibilidade humana? Ou totalmente, como uma máquina de eficiência e produtividade?

Também é preciso considerar a eficácia, em termos de sua capacidade. Em outras palavras, em que medida os algoritmos de IA podem avaliar aspectos como criatividade, originalidade de pensamento e sutilezas culturais? Qual relação de proximidade a automação pode conseguir, considerando as características, potenciais e limitações de cada aluno?

De forma relacionada, a falta de consistência e alucinações. Neste momento de desenvolvimento tecnológico, as IAs generativas podem apresentar inconsistências e comportamentos imprevisíveis. Numa situação destas, a idoneidade da avaliação seria comprometida.

E logo, a presença de vieses, tema recorrente da introdução da IA na sociedade. Os sistemas de IA são tão bons quanto os dados com os quais são treinado e aqui corremos o risco, alertado pela Unesco, de viés cognitivo. Conforme os algoritmos favoreçam estilos de escrita e vocabulários específicos, acabam prejudicando os alunos que não seguem esses padrões, muitas vezes por motivos culturais ou socioeconômicos.

A falta de transparência nos critérios de julgamento, por sua vez, é outro ponto a ser tratado. A opacidade algorítmica esconde os critérios do por quê uma determinada nota foi atribuída. Ou ainda mais, pode naturalizar erros sistêmicos, comprometendo a eficácia do sistema de avaliação.

Finalmente, a dimensão afetiva do processo de avaliação. Os sistemas de IA ainda não são capazes de fornecer orientação motivacional e emocional no mesmo patamar que o proporcionado pela dimensão pessoal de professores. Com isso, o processo de aprendizado pode ser menos rico e menos engajador para os estudantes.

Diante de todos estes "poréns", a implementação da IA na avaliação demanda cuidado e olhar crítico. Apesar do potencial - e das promessas de rapidez e redução de custos - sua utilização em processos de seleção como são vestibulares ou o próprio ENEM aponta para um cenário de injustiça e de falta de equidade.

IA em Ação

O GPT consegue avaliar respostas abertas? Um estudo utilizando 1.710 respostas de alunos a perguntas de Ciência e História e comparou o desempenho do GPT-4 com avaliadores humanos. Utilizando prompts com alguns poucos exemplos de orientação de correção (few shots prompts) os resultados mostraram variação mínima no desempenho do modelo com base no assunto, nível de escolaridade ou dificuldade da pergunta. Com desempenho próximo ao humano, o GPT-4 levou apenas duas horas para completar a tarefa, em comparação as mais de 11 horas estimadas que professores demandariam.

Contudo, cabe questionar o quão tradicional estas perguntas e respostas eram, no sentido de avaliar o quanto os alunos recordavam uma informação. A contraposição seria questões que exigissem a aplicação ou a síntese de informações, de forma relevante.

Além disso, também cabe considerar em pesquisas futuras como professores interagem com a tecnologia, incluindo como eles lidam com desacordos sobre notas e quais são os impactos na aprendizagem dos alunos

Prompt da Semana

Seguindo nossa temática, apresentamos um prompt que auxilia o professor na elaboração de rubricas de avaliação. Antes, comentar um pouco sobre o conceito e como utilizá-lo.

Uma rubrica é uma ferramenta de avaliação que estabelece critérios claros e específicos para avaliar o desempenho dos alunos em uma tarefa ou projeto. Apresentada na forma de tabela ou lista, detalha os diferentes aspectos a serem avaliados e descreve níveis de qualidade para cada critério, geralmente usando uma escala numérica ou descritiva. Para utilizá-la, primeiro é preciso definir os objetivos de aprendizagem e os critérios relevantes, assim como descrever os diferentes níveis de desempenho. Dessa forma, proporcionam objetividade e consistência ao processo de avaliação, ao mesmo tempo que comunica as expectativas para os alunos.

Dito isso, acredito que este é um bom uso da IA generativa, pois elaborar rubricas exige um certo esforço de tempo e de criatividade que pode

Acesse o comando em nossa biblioteca de prompts.

Momento de Reflexão

Os MLLs (Grandes Modelos de Linguagem) são atualizados regularmente e secretamente pelos desenvolvedores, frequentemente resultando em mudanças consideráveis no desempenho (saída). Sem sequer uma notificação, muito menos documentação, a exemplo de notas de lançamento que informem aos usuários o que foi alterado. Esses modelos também são projetados para aprender continuamente e modificar suas ponderações à medida que os usuários interagem com eles; são construídos para treinar com dados dos usuários. Os MLLs funcionam de maneira diferente de semana para semana, de dia para dia.

Conforme, colocado por Mark Basset.

Ou seja, até que tenhamos uma estabilidade na tecnologia, não podemos considerar o uso de modelos de linguagem para a avaliação educacional de forma consistente e sistemática.

Queremos ouvir você! Suas ideias e experiências são valiosas para aprofundar esta conversa. Não hesite em compartilhar seus pensamentos, relatos ou dúvidas conosco.